Anthropic и Пентагон расходятся во мнениях относительно ИИ для наведения на цели и надзора в США

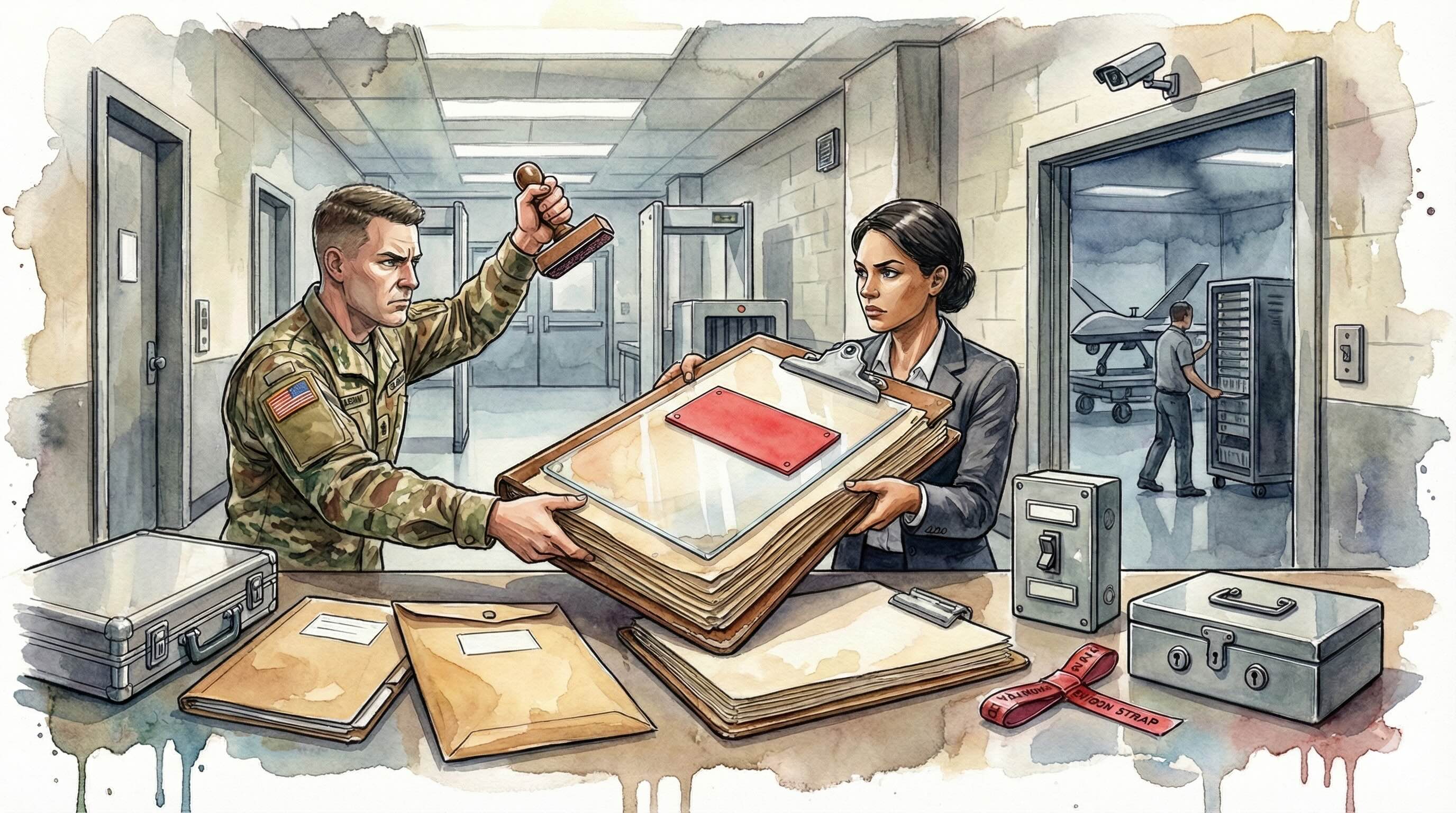

После нескольких недель переговоров Пентагон и Anthropic остаются в конфликте по поводу ослабления ограничений на ИИ, что может позволить автономное наведение на цели и внутренний надзор в США, сообщает Reuters.

Переговоры между Пентагоном и разработчиком ИИ Anthropic зашли в тупик из-за вопроса, ослаблять ли предохранители в системах компании — изменения, которые, по словам вовлеченных лиц, могут открыть путь к автономному наведению оружия на цели и внутреннему надзору в США, сообщает Reuters. После нескольких недель переговоров стороны остаются далекими друг от друга в отношении условий контракта, который регулирует чувствительные сценарии использования.

Лица, осведомленные о переговорах, описали спор о том, могут ли государственные пользователи обходить политики использования Anthropic, когда операция является законной по законам США. Представители оборонного ведомства настаивают на гибкости, чтобы применять коммерческий ИИ в различных миссиях, несмотря на запреты поставщиков на наведение на цели и применение в надзорных целях.

Чиновники ссылались на меморандум Минобороны от 9 января о стратегии ИИ, чтобы обосновать позицию, что департамент может внедрять коммерческие инструменты, пока деятельность соответствует законодательству США. Anthropic сопротивлялся формулировкам, которые отменяли бы или ослабляли ее предохранители, утверждая, что эти механизмы являются неотъемлемой частью того, как ее системы создаются и администрируются, по словам этих людей.

Anthropic — один из нескольких поставщиков ИИ, которых оценивают для работы в сфере национальной безопасности. Тупик замедлил прогресс в отношении потенциального соглашения после нескольких раундов переговоров в этом месяце.

Несколько человек, знакомых с процессом, сказали, что политики компании подпитывали разногласия с администрацией Трампа, которая продвигает более быстрое внедрение коммерческого ИИ в оборонных и разведывательных программах. Стороны не пришли к общему пониманию относительно приемлемых способов использования.

Пентагон не предоставил комментариев в ответ на запросы. В заявлении Anthropic написала, что ее ИИ «широко используется для миссий национальной безопасности правительством США, и мы ведем продуктивные обсуждения с Министерством войны о путях продолжения этой работы».

В рамках дискуссий рассматривались операционные детали, в частности, могут ли федеральные пользователи отключать функции безопасности в ограниченных случаях, как будут работать аудит и надзор, если ограничения компании останутся в силе, и кто будет уполномочен выполнять срочные задачи по наведению на цели или надзору. Обе стороны прорабатывали технические и политические варианты, но не согласовали обязательные условия.

Позиция Anthropic, по словам осведомленных источников, заключается в том, что ослабление мер предосторожности для любого клиента может создать более широкие риски и затруднить соблюдение требований во всей ее базе пользователей. Компания настаивает, что последовательное применение ее политик необходимо, чтобы предотвратить злоупотребления.

Хотя обсуждения продолжаются, застой отсрочил сделку, и непонятно, переключится ли Пентагон на других поставщиков или вернется к столу переговоров с пересмотренными условиями.

Как мы писали ранее, Anthropic, разработчик моделей Claude, обсуждает раунд примерно на $10 млрд, который может поднять ее оценку до около $350 млрд, с потенциальными ведущими инвесторами GIC и Coatue. При таких условиях оценка почти удвоилась бы по сравнению с сентябрем 2025 года.

Материалы на GNcrypto предоставляются исключительно в информационных целях и не являются финансовой рекомендацией. Мы стремимся публиковать точные и актуальные данные, однако не можем гарантировать их абсолютную достоверность, полноту или надёжность. GNcrypto не несёт ответственности за возможные ошибки, упущения или финансовые потери, возникшие вследствие использования данной информации. Все действия вы совершаете на свой страх и риск. Всегда проводите собственный анализ и консультируйтесь с профессионалами. Подробнее см. в наших страницах Условия, Политика конфиденциальности и Отказ от ответственности.